A principios del año pasado, Elon Musk se lanzó a la carrera de la inteligencia artificial (IA) con su propia empresa llamada xAI. La idea del empresario era competir con OpenAI, Microsoft o Google, pero para enfrentarse a estos rivales necesitaba un supercomputador cuyo rendimiento estuviera a la altura.

Tras lanzar las primeras versiones de Grok, un rival de ChatGPT, xAI estrenó el pasado mes de julio el «clúster de entrenamiento IA más potente del mundo», una bestia con 100.000 GPU H100 de NVIDIA situada en Memphis, Tennessee. Ahora tenemos más detalles sobre este proyecto que se ha estado desarrollando contrarreloj.

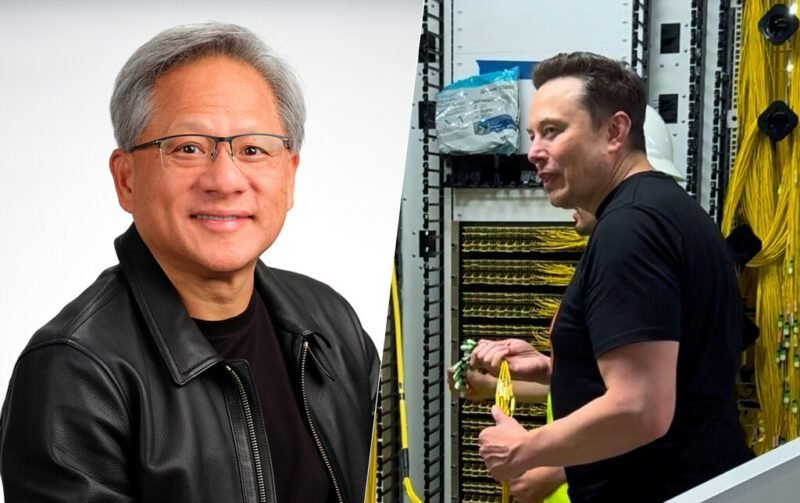

La información proviene de una conversación que el CEO de NVIDIA, Jensen Huang, mantuvo con los presentadores del podcast BG2. Huang explicó que el equipo de xAI pasó de la etapa de concepto a la integración completa de las 100.000 unidades de procesamiento en solo 19 días, un hito alcanzado con la primera tarea de entrenamiento, promocionada por Musk en X.

Montar un centro de datos en 19 días es un logro impresionante. Huang explicó que el proceso implicó no solo montar las GPU, sino también equipar las instalaciones con un sistema de refrigeración líquida y un sistema de alimentación para que los chips pudieran funcionar. “Solo hay una persona en el mundo que podría hacer eso”, dijo Huang, destacando la colaboración con los equipos de software, redes e infraestructura de xAI.

Según sus cálculos, poner en marcha un supercomputador de 100.000 GPU suele tardar unos cuatro años. Tres años se dedicarían a la planificación, mientras que el último año se recibiría el equipo, se instalaría y se probaría. Montar un centro de datos dedicado a soportar altas cargas de trabajo es un auténtico desafío.

Huang también explicó que la integración de 100.000 GPU H100 “nunca se había hecho antes”, y que no se verá en otra compañía durante un tiempo. El clúster de xAI cuenta con tecnología de acceso directo de memoria remota (RDMA), que ofrece transferencias de datos rápidas y eficientes, mejorando el rendimiento. Además, se trata de una solución escalable, que podrá ser ampliada con el tiempo, presumiblemente con GPU H200.

Imagen: Nvidia (1,2) | xAI